|

相關閱讀 |

未來10年,學什么不會失業?|專訪《人類簡史》作者尤瓦爾·赫拉利

|

>>> 技術話題—商業文明的嶄新時代 >>> | 簡體 傳統 |

人的一天只有 24 小時,一份合理的安排是 8 小時睡覺,8 小時工作,另外 8 小時自由娛樂。可我們卻經常感到時間不夠用,或者是另一個極端——不知不覺,時間就不見了。

互聯網危機感始終籠罩著年輕人。在老一輩看來,Z時代青年玩轉網絡、懂得很多,能做到許多他們做不到的事;但年輕人在互聯網里泡得越久,越覺得自己好像永遠 2G 網速,什么都不知道。

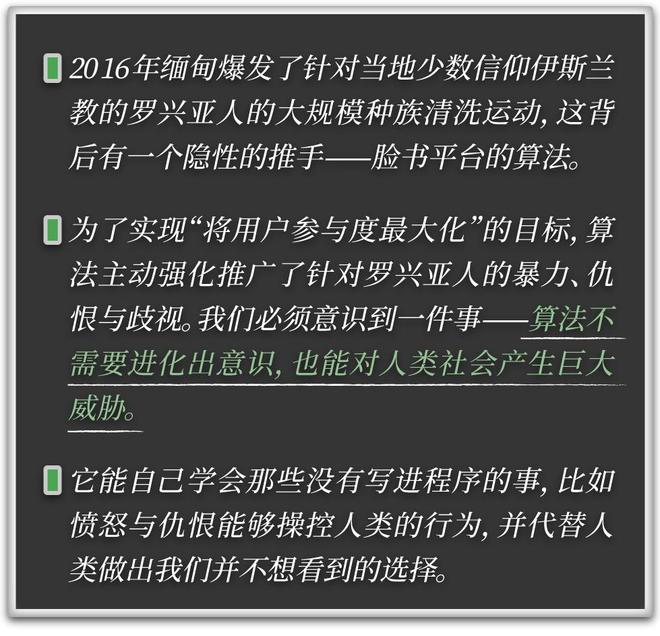

在這焦慮感的背后,無處不在的算法卻永恒地奔跑者,新聞永不停歇,市場永不休市,社交網絡永遠運轉。

算法帶來了強烈的社交媒體倦怠。我們通過大數據系統打分選擇衣食住行,通過電子屏幕待在算法為我們準備的信息繭房里,甚至通過虛擬的聊天軟件建立和真實的人的連接——卻還時常有種搭不上時代列車的感覺。

十幾年前,尤瓦爾·赫拉利撰寫《人類簡史》時就已經做出過這樣的預言:幾千年萬年來,人類能夠站在智人頂峰、發展進化出繁榮的文明就在于我們擁有講故事的能力。我們能夠創造并相信虛構的概念,諸如法律、宗教、公司和國家,它們有效地維持著人類社會的運行秩序。

然而,計算機的發展卻可能超越人類在決策、數據處理和創造力方面的能力,逐漸取代人類在社會中的主導地位。

這個預言正在一步步變為現實。

從 2018 年他開始撰寫新書《智人之上:從石器時代到 AI 時代的信息網絡簡史》,伴隨著人工智能大爆發的背景,他更加關心這會對普通人產生什么影響。

“我們是有機動物,按照晝夜、夏冬的有機循環規律生活,有時活躍,有時放松。但現在,我們被迫生活在永不休息的計算機主導的環境中。它們也逼迫著我們保持永遠活躍——但如果你強迫一個有機體永遠活躍,結局一定是崩潰而死。”尤瓦爾·赫拉利對 36 氪“后浪研究所”說。

很多年輕人也意識到信息網絡對自己的負面影響,他們開始主動訓練算法、挑戰 XX 天不用手機、戒斷網絡、不用社交媒體——但人不可能逆勢而為,永遠隔絕算法。在信息時代,如何與不確定性和焦慮自處是每個人必修的課題。

這本新書正是關于一個碳基生物在硅基世界中,應該如何做好準備來適應這個無機硅芯片主導的世界。36 氪“后浪研究所”采訪到尤瓦爾·赫拉利,和他聊了聊中國年輕人時代情緒的變化,與他們最關心的問題。

算法在掌控我們的注意力。

我看過一個段子,說一個年輕人打開手機想幫受傷的朋友叫一輛救護車,結果被彈窗帶到短視頻平臺點開就是刷,完全忘了朋友受傷的事。

現在很多人都在反省,自己已經失去了主動檢索信息的能力,大部分都在被動地接收信息,如果從歷史學的視角看,人類是在什么時候開始逐漸遺失這項能力的?

赫拉利:

要理解我們對信息的消費方式發生了什么變化,可以用食物做個比喻。100 年前食物很稀缺,所以人們吃他們能找到的一切食物,并且大家喜歡富含脂肪和糖的能量充足的食物。時至今日食物已經很充足了,如果人們還是什么都吃,過量攝入脂肪和糖的話就會生病。所以大家開始節食。

信息也是一樣。在過去信息很稀缺,所以我接受能獲得的任何信息。現在我們已經被大量信息淹沒,尤其是那些無用信息——這也會讓我們生病。我們需要進行信息節食。

信息節食的第一步就是放棄“更多信息總是對我們有益”這樣的想法。第二步則要有意識地篩查信息質量。就像我們必須對攝入的食物謹慎一般,我們也應該對放入大腦的精神食糧謹慎。特別要注意,避免用過量的仇恨、貪婪和垃圾信息填滿大腦。

現在許多國家都會為垃圾食品標注成分表——“這含有 40% 的糖,20% 的脂肪”。也許我們也應該強迫信息提供者們做同樣的事情,比如在觀看某些視頻前,列出該視頻包含的內容——“這含有 40% 的貪婪,20% 的仇恨”。如果你想攝入一些這樣的“有害”信息,至少要理解它的危害性。

最后,定期開展“信息斷食”是有益的。我個人每年會進行為期幾周的冥想閉關,期間完全斷開與外界的聯系。我不看新聞,不讀任何電子郵件,不寫書,只冥想。我花時間來消化我的頭腦已經攝入的信息,而不是填充更多。對大多數人來說幾周是有點長了,但偶爾進行一兩天的禁食也是不錯的選擇。

然而互聯網時代的“信息焦慮”無處不在。

以前我們總覺得知道得越多越好,一天沒瀏覽社交媒體就擔心自己錯過什么。但現在我們開始難以區分究竟哪些是有效信息,而那些看似無效的信息又是不是真的不被需要。說到底,你認為哪些信息能稱得上知識?

赫拉利:

是的,以前我們將所有信息等同于知識,覺得擁有的信息越多,擁有的知識也就越多。很明顯這是錯誤的——大多數信息都是垃圾,而知識是那一小部分稀有且昂貴的信息。

想編造一個引人入勝的“假新聞”是很容易的——你只需隨心所欲地寫,無需花費一分鐘進行研究。但相比之下,寫一篇真實的報道則很困難,因為這背后需要做的研究費時費力。而且,你所寫的真相收獲的關注度可能遠小于“假新聞”,因為事實往往很復雜,而人們不喜歡復雜的故事。這也就導致錯誤的信息總是會比真相傳播得更容易。

所以為了保護那些稀缺而珍貴的知識,我們需要自我修正機制——主動去識別、承認并糾正錯誤。

“自我修正機制”在大自然中無處不在,兒童學會走路就是依靠有效的自我修正機制:你邁出一步,摔倒了,再嘗試稍微不同的方式,再次摔倒,再次糾正自己,直到做對——科學也是這樣運作的。我們提出一個模型,效果不佳,我們就承認錯誤、改變模型。在政治中亦然,好的政府會承認錯誤,并相應地調整政策,而暴君和宗教狂熱者聲稱自己是完美無缺的,聲稱自己什么都懂,從不犯任何錯誤。他們永遠不去學習,也不值得被信任。

所以,如果有人拒絕承認錯誤,永遠不要相信他們。如果有人承認錯誤,他們就是真正的知識源泉。

延續上一個問題,近幾年“知識無用論”,尤其是“文科無用論”甚囂塵上。

當很多名校畢業的年輕人畢業即失業,找不到工作時還是會陷入迷茫——早知道就學數理化了。如您所言,人類更擅長講故事,但這種能力如今卻成了利益最小的、效率最低的領域,被大家所摒棄。您怎樣看待這種現狀?

赫拉利:

現在人們覺得就業前景有很大的不確定性,人工智能迅速改變了就業市場,以至于我們無法預測未來還需要哪些技能。對理工科的認知也是一樣,很多人覺得學編程、代碼很重要,因為計算機是未來。但幾年后,AI 編碼可能比人類更好,那是不是我們也不需要人類程序員了?相反,也許到時候我們會更需要哲學家、心理學家,因為世界劇變會帶來更多哲學和心理問題。

舉個例子,要實現車輛智能無人駕駛,我們必須將道德規則也編碼到駕駛程序中。那假如出現緊急情況,車輛必須為了救行人而危及車內乘客的安全呢?也許并不需要人類程序員解決此類問題,因為 AI 可以編寫這段代碼,但(我們)卻需要人類哲學家來為 AI 制定道德規則。

同樣,理工科專家也無法告訴你 AI 會如何影響人類心理健康、親密關系和社會生活。為此你需要歷史學家、心理學家和藝術家。看看我們周圍的世界——計算機科學家發明了社交媒體算法,但他們不能預見算法對兒童的負面影響。你認為誰最適合幫助改善兒童處境——研究計算機的人,還是研究人類的人?

算法也在影響我們的行為。

現在我們習慣于在吃穿用度上都聽聽算法是怎么評分的,甚至包括親密關系的潛在對象也可以用軟件量化。但反而我們感覺很多事都變難了——高評分的餐館也可能不好吃,軟件匹配到的人也合不來。算法真的提升了效率嗎?為什么我們覺得生活越來越無聊了?

赫拉利:

依賴算法來評價一切的做法會帶來毀滅性的影響。逐漸地,我們都被迫變成“被動的消費者”,而不是“主動的生產者”。

以親密關系為例,我可以試著通過算法匹配來找到另一半。如果要這么做,前提一定是假設在世界某處真的存在這樣一位真命天子——我只需要找到他或她。這就像一個非常困難的尋寶游戲,地球上有 80 億人,我要怎么找?

為了解決這個問題,我把這份工作外包給了算法。我自己不需要做什么,只需要坐下來等待算法大顯神通就行了。基于海量數據,算法會為我潛在的對象們打分,讓我試試那些最高評分的人。如果我對這些“產品”不滿意,我就直接把它丟回架子上,等著算法給我推更好的產品。反正我的靈魂伴侶仍然在世界某處,算法遲早會為我找到他的是不是?

這種態度很可怕,它刺激著我們不斷因為微小的瑕疵而拒絕潛在候選人,轉而去等待一個完美的人出現——反之它不會鼓勵我來改變自己,我只是被動地在接受“伴侶”這項產品。

但我們也可以試試另一種做法——把人類看成親密關系的創造者,而不是消費者。問題壓根不是如何找到完美伴侶,“完美伴侶”是不存在的。真正的問題是,無論算法為我找到誰,我都需要通過自己的努力去建立一段良好的關系。找到愛真正的困難之處不是找到那個難以捉摸的靈魂伴侶,而是每天努力去與身邊真實存在的人建立關系,并努力改變自己的行為和思維模式里的問題。這項工作,我不能指望任何算法來替我完成。

很多人都在擔心 AI 取代我們的工作,也有一部分人覺得無須擔心,至少 10 年內 AI 還無法理解人類的創造力和共情能力。

對此你怎么看?如果要為即將到來的人工智能時代做技能和知識儲備,又或者說心理準備,你會給Z時代年輕人怎樣的建議?

赫拉利:

誠然,AI 將會改變就業市場,但我們很難準確預測哪些工作會發生變化或消失。在這個問題上,直覺判斷可能會帶來誤導。

例如,我們通常認為醫生比護士更重要,至少從薪水和社會地位來看是的。但人工智能可能更容易取代醫生而不是護士。為什么?許多醫生的工作主要是分析數據,他收到大量關于我的癥狀和病史的數據,他們分析數據、診斷疾病,并推薦治療方案。這種數據分析恰恰是人工智能的優勢,它們馬上就能比人類做得更好。

但護士的工作就不僅是分析數據了,他們還需要良好的動手能力和社交技能來換繃帶、給哭泣的孩子注射疫苗。這都是更難自動化的事情。因此,人工智能醫生可能會出現得比機器人護士快。

因此,如果要給年輕人一些建議,最安全的做法是去更廣泛地學習技能,而不是專注于某種垂類技能,比如編程。他們應該提升動手能力、發揮同理心,就像過去鍛煉智力一樣,運動技能和社交技能同樣重要。當然最重要的就是——能夠在一生中不斷學習和改變。要在 21 世紀蓬勃發展,你需要一個非常靈活的頭腦。

那么如何培養一個靈活的頭腦呢?你要先了解你的頭腦是如何工作的。你的思維和感情來自哪里?為什么你喜歡某些事物而討厭其他事物?是什么塑造了你的恐懼和欲望?有些人會通過冥想來探索這些問題,還有的通過心理治療、藝術或運動解決。無論哪種方法適合你,你都要在上面投入時間和精力。了解自己的頭腦是你能給自己的最好的禮物。

“人工智能不必發展出意識也能做決策,威脅到人類文明”,根據目前 AI 發展的態勢,最先受到沖擊的會是哪些行業領域?你覺得未來 5 年(以現在的發展速度來說 10 年都有點太久了),人類世界的秩序會迎來怎樣重大的改變?

赫拉利:

人工智能對世界秩序的威脅很好理解,例如某個暴君用 AI 控制他國的核武器,或者恐怖分子指示 AI 制造新的流行病。再想象一下對金融界,對于 AI 來說,金融是它們理想的游樂場——這是一個純粹的信息和數學領域。人工智能仍然很難自主駕駛汽車,因為這需要在混亂的物理世界中移動交互。你很難在物理世界定義什么是“成功”,但在數字世界里,數學是很容易界定“成功的”,用 AI 處理貿易,更多的美元就等于任務完成。

假設一家投資基金會分配給 AI 一項任務,讓其賺取盡可能多的美元,人工智能不僅能制定新的投資戰略,甚至還可能開發出完全超越人類理解的全新金融工具。

或許幾年來一切都很美好,AI 發明的新金融工具導致市場飆升,投資者賺取了數萬億美元,可再然后,如果出現了比 2008 年金融危機更大的崩盤該怎么解決?人工智能創造的金融工具就是一個黑匣子,就算事實證明它存在危險的缺陷,人類也沒有辦法監管它,因為金融學家和政客都不懂它的運行原理。

社交媒體會重復放大那些人類社會的錯誤,更令人憂心的是我們很難察覺哪些判斷是由算法決定的。

比如重男輕女思想和“白幼瘦審美”,其實很多人在抵制,但這些抵制的聲音不會傳遞到支持它的人們的手機中去。那么,想要自己保持開放的思想和自我修正機制,我們應該怎么做?

赫拉利:

正如前文所述,最重要的是更好地了解我們自己的思想,因為算法會利用我們自身的弱點來對付我們。操縱性算法不能無中生有地制造貪婪與仇恨,它們需要發現你內心已有的渴望和仇恨,才能按下你情緒的按鈕,操控你完成他想做的事。

自古以來,智者們一再建議人們要先“知己”。然而,在佛陀和孔子的時代還沒有這么大的壓力。如果你不想了解自己,對于其他人來說,你依然是一個黑匣子,沒人能猜透你。但現在情況不同了——當你閱讀這些文字時,各大公司和機構的算法都在努力解讀你這個人。如果算法比你還要更了解你自己,他們就可以輕松地操縱你。所以,這個時代要求我們必須努力去“知己”。

《人類簡史》中你提到人類文明“分久必合才是不變的大趨勢”。那么在人工智能登上歷史舞臺后,這個結論依然不變嗎?

可我們為什么會覺得在后疫情時代,人們似乎越來越無法理解他人的話語了?尤其是那些和自己不同的人。

赫拉利:

確實很不幸,當下我們看到全球合作在減少,國際緊張局勢升級。這非常危險,因為任何一個國家,無論多么強大,都無法單憑自身來阻止生態環境崩潰、避免第三次世界大戰,或者規范人工智能。如果各國不能就這些問題找到合作方式,人類將會毀滅。

盡管如此,一些政客反對全球合作,因為他們認為這是“反愛國主義”。這是一個危險的錯誤——愛國主義與全球主義并沒有矛盾,愛國主義并不意味著仇視外國人。愛國主義需要熱愛你的同胞,但確保你同胞的安全和繁榮是需要與其他國家合作的。就像環境和人工智能的問題,善于全球合作就是一種愛國的行為。

坦白說,作為內容從業者我們也深深感覺越來越難做。閱讀量高的文章和真正有價值的文章往往是兩回事,但往往是閱讀量高的文章才會正向反饋在我們的工資上。作為信息的加工生產者,媒體又該怎樣應對這場和算法的戰爭?

赫拉利:

首先我們應該時刻保持責任感。媒體生產和發布的信息就像播種在數百萬人心中的種子,如果我們在數百萬人心中播下貪婪、仇恨或無知,將會在極大范圍內造成痛苦。其次,我們不應對算法機制感到絕望——這并不是我們在對抗算法的嘗試中失敗了,而是因為我們根本還沒有嘗試過。

汽車行業是個很好的對比項。每個人都認同,當一個公司生產汽車時,他們必須投入大量預算和精力來保證安全,現在也有許多規定來限制汽車的行駛方式。但當公司開發算法時,他們幾乎不投入任何資源來保證賽博世界的安全,也沒有什么規定限制算法在世界的運行。這是非常危險的,因為算法比汽車強大得多,它可以造成更多生理和心理上的損害。

因此,我們應該將對待汽車的原則也應用于算法上,人工智能公司應該至少將其預算的 20% 投入安全研究,而人工智能也必須像汽車一樣遵守人類世界的規則,媒體應當鼓勵公眾和政府支持這些政策。

2024-10-08 18:17:42

評論集

暫無評論。

稱謂:

内容:

返回列表